열려있는 정책플랫폼 |

국가미래연구원은 폭 넓은 주제를 깊은 통찰력으로 다룹니다

※ 여기에 실린 글은 필자 개인의 의견이며 국가미래연구원(IFS)의 공식입장과는 차이가 있을 수 있습니다.

관련링크

본문

자전거 타기를 배울 때 수없이 넘어지면서 시작한다. 그러나 다시 시도해 균형을 잡는 시행착오를 거듭해 학습한다. 이러한 학습방법을 강화 학습이라 한다. 강화 학습은 정답이 명확지 않고 시행착오를 통해 학습되며, 피드백(보상)이 결과적으로 판단되는 경우 주요한 학습방법으로 사용되고 있다. 주어진 환경과의 상호작용의 결과에 따라 배워나가는 상황에서 단기적인 보상보다 장기적인 보상을 목표로 하는 경우가 많다. 인간이 처한 복잡하고 다양한 문제 해결에 많은 부분이 강화 학습으로 해결이 가능하다고 한다.

1. 인공지능에서의 강화학습

인공지능에서도 강화 학습이 대단한 역활을 하고 있다. 중국의 딥시크 R1 모델은 개발 단계에서 강화 학습 (Reinforcement Learning)이 주로 사용되었다고 한다. 최근 각광을 받고 있는 이러한 학습방법은 뇌 보상 시스팀 (Brain Reward System)의 메카니즘에서 아이디어을 얻고 있다. 사람은 특정 행동이나 자극에 대해 보상을 느끼게 하여 그 행동을 반복하도록 유도하는 뇌 보상 시스템을 가지고 있다고 한다. 이 시스템은 행동의 결과로 받는 보상에 따라 결정을 내리거나 행동을 조정한다는 점에서 강화 학습과 긴밀히 관련되어 있다.

AI 강화 학습은 에이전트(AI 모델에서의 가상적인 행동주체)가 최적의 행동 전략이나 규칙을 학습하도록 하는 것이 목표다. 에이전트에게 적절한 보상과 벌을 줌으로 최적의 행동 정책(policy)을 학습시키는 과정으로 설계되어 있다.

모델의 주요 요소는 다음과 같다:

-에이전트 (Agent): 환경과 상호작용하며 학습하는 주체.

-환경 (Environment): 에이전트가 관찰하고 행동하며 영향을 받는 외부 세계.

-행동 (Action): 에이전트가 환경에 반응하여 취할 수 있는 선택.

-보상 (Reward): 행동의 결과로 얻는 피드백.

-가치 함수 (Value Function): 특정 상태에서 미래 보상의 기대치를 평가.

이와 같은 요소들을 구비하고 다음과 같은 작동과정을 거쳐 강화 학습을 수행하도록 설계되어 있다.

1. 에이전트는 현재 상태를 관찰한다.

2. 주어진 정책(policy)에 따라 행동을 선택한다

3. 결과로부터 보상(reward)을 받고 새로운 상태로 이동한다

4. 이 과정을 반복하면서 최대의 보상을 얻는 최적의(optimization) 방법을 학습한다

보상을 설정하는 방법으로 종종 사람이 개입하는데, OpenAI RLHF(Reinforcement Learning from Human Feedback)라는 강화 학습 방법을 사용하여 ChatPGT를 만들었다고 한다. 이 학습방법은 모델이 생성한 여러 답변에 대해 사람이 순위를 매긴다. 이 순위 데이터를 바탕으로 답변의 품질에 비례하는 보상을 최대화하는 학습을 한다. 이러한 방법으로 ChatGPT 답변의 품질을 향상 시킬 수 있었다.

AI 강화 학습의 개념적 설계는 뇌 보상 시스템 메카니즘에서 유래됬다. 사람은 생존과 적응에 유리한 행동을 강화하고 있다. 이때 특정 행동 후 기대 보상과 실제 ‘보상의 차이’에 따라 뇌의 도파민 뉴런이 활성화 된다. 보상의 차이는 자극(음식, 돈 등)이나 즐거움과 관련된 뇌신경적 반응을 유도 하는데, 그 정도는 도파민 분비로 측정된다고 한다. 이 신호는 학습과 행동 수정에 중요한 역할을 하며, 보다 나은 결과를 얻도록 돕는다.

AI의 강화 학습은 뇌의 보상 시스템, 특히 도파민 뉴런의 작동 방식을 수학적으로 모델링한 결과다. 두 시스템은 보상 기반 학습 원리를 공유하며, 인간의 뇌에 대한 이해가 AI의 발전에 영감을 주고, 반대로 AI 연구는 뇌의 학습 메커니즘을 분석하는 데 도움을 주는 상호보완적인 관계를 갖고 있다.

강화학습(Reinforcement Learning)은 인공지능의 한 분야로, 에이전트(agent)가 환경과 상호작용하면서 시행착오를 통해 학습하는 방법입니다. 다음과 같은 주요 개념으로 구성됩니다:

1. 에이전트(Agent): 학습하고 행동을 수행하는 주체

2. 환경(Environment): 에이전트가 상호작용하는 공간

3. 상태(State): 현재 환경의 상황

4. 행동(Action): 에이전트가 취할 수 있는 선택들

5. 보상(Reward): 행동의 결과로 받는 피드백

작동 과정:

-에이전트는 현재 상태를 관찰합니다

-정책(policy)에 따라 행동을 선택합니다

-환경으로부터 보상을 받고 새로운 상태로 이동합니다

-이 과정을 반복하면서 최대의 보상을 얻는 방법을 학습합니다

실제 응용 사례:

-게임 AI (알파고, 아타리 게임 등)

-로봇 제어

-자율주행

-추천 시스템

-자원 관리 최적화

강화학습의 장점은 명시적인 답을 알려주지 않아도 스스로 최적의 전략을 찾아낼 수 있다는 것입니다. 반면 학습에 많은 시간이 필요하고, 실제 환경에서의 시행착오가 위험할 수 있다는 단점이 있습니다.

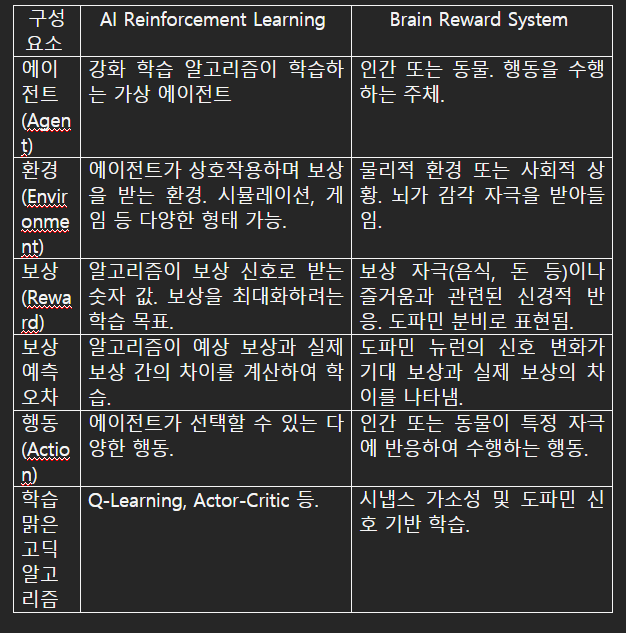

2. 주요 구성 요소의 비교

3. 보상 예측 오차의 역할

- AI Reinforcement Learning:

○ 보상 예측 오차는 알고리즘에서 매우 중요한 신호로, 학습 과정에서 정책(policy)을 업데이트하는 데 사용됩니다.

○ 수학적으로, δ=r+γV(s′)−V(s)\delta = r + \gamma V(s') - V(s) 여기서 δ\delta는 보상 예측 오차, rr은 보상, γ\gamma는 할인율, V(s)V(s)는 상태 ss의 가치.

○ 이 값이 클수록 정책이 크게 수정되어 미래 행동에 영향을 줍니다.

- Brain Reward System:

○ 도파민 뉴런은 보상이 기대치보다 클 경우 더 많은 도파민을 분비하며, 예상보다 보상이 적으면 도파민 분비가 감소합니다.

○ 이 신호는 학습과 행동 수정에 중요한 역할을 하며, 뇌가 행동의 결과를 학습하도록 돕습니다.

○ 예: 음식 섭취 후 기대 이상의 만족감을 얻었을 때, 해당 행동(음식을 먹는 행동)이 강화됩니다.

4. 시간차 학습 (Temporal Difference Learning)의 유사성

AI와 뇌 모두 미래 보상을 고려하여 현재의 행동을 평가합니다.

- AI 강화 학습:

시간차 학습(TD Learning)은 미래의 예상 보상에 따라 현재 상태의 가치를 업데이트합니다.

- 뇌 보상 시스템:

도파민 신호는 시간이 지나면서 기대 보상이 수정되고, 이를 통해 미래의 의사결정에 영향을 줍니다.

5. 의의 및 차이점

유사점:

- 둘 다 보상을 기반으로 최적의 행동을 학습하며, 보상 예측 오차와 같은 핵심 개념을 공유합니다.

- 도파민 신호는 강화 학습의 보상 신호와 동일한 역할을 수행합니다.

- 행동의 결과가 학습에 반영되어 다음 행동을 조정하는 피드백 루프가 존재합니다.

차이점:

1. 복잡성:

a. 뇌는 뉴런과 시냅스의 복잡한 상호작용을 통해 병렬적이고 비선형적인 학습을 수행합니다.

b. AI 강화 학습은 수학적으로 단순화된 모델에 기반하며, 주로 선형적인 방식으로 작동합니다.

2. 보상의 형태:

a. AI는 명시적이고 수치화된 보상을 사용합니다.

b. 뇌는 감각적 자극, 감정, 호르몬 변화 등 다양한 형태의 보상을 처리합니다.

3. 적응성:

a. 뇌는 학습과 동시에 여러 요소(감정, 기억 등)를 고려합니다.

b. AI는 지정된 알고리즘과 환경 내에서만 학습합니다.

결론

AI의 강화 학습은 뇌의 보상 시스템, 특히 도파민 뉴런의 작동 방식을 수학적으로 모델링한 결과라 볼 수 있습니다. 두 시스템은 보상 기반 학습 원리를 공유하며, 인간의 뇌에 대한 이해가 AI의 발전에 영감을 주고, 반대로 AI 연구는 뇌의 학습 메커니즘을 분석하는 데 도움을 주는 상호보완적인 관계를 갖고 있습니다.

##########

강화 학습( Reinforcement Learning, RL)은 기계 학습의 한 분야로, 에이전트가 환경과 상호작용하며 보상을 최대화하는 행동 방식을 학습하는 방법론입니다. 이 개념은 인간의 뇌신경 시스템, 특히 도파민 회로의 작동 방식과 자주 비교됩니다. 이를 이해하기 위해, 강화 학습의 핵심 개념과 도파민 회로의 주요 특징을 살펴보겠습니다.

1. 강화 학습의 개념

강화 학습은 보상과 벌을 기반으로 최적의 행동 전략(정책, policy)을 학습하는 과정입니다. 주요 요소는 다음과 같습니다:

- 에이전트 (Agent): 환경과 상호작용하며 학습하는 주체.

- 환경 (Environment): 에이전트가 관찰하고 행동하며 영향을 받는 외부 세계.

- 행동 (Action): 에이전트가 환경에 취할 수 있는 선택.

- 보상 (Reward): 행동의 결과로 얻는 피드백. 긍정적 보상은 강화하고, 부정적 보상은 억제.

- 가치 함수 (Value Function): 특정 상태에서 미래 보상의 기대치를 평가.

강화 학습의 목표는 에이전트가 최대의 장기적인 보상을 얻기 위해 올바른 행동을 학습하는 것입니다.

2. 도파민 회로의 작동 방식

뇌의 도파민 시스템은 보상 기반 학습에 중요한 역할을 합니다. 이는 강화 학습의 수학적 모델과 놀랍도록 유사한 구조를 가지고 있습니다.

- 도파민 뉴런: 특정 행동이나 사건의 결과가 기대보다 좋거나 나쁠 때 활성화됩니다.

- 보상 예측 오차 (Reward Prediction Error): 실제 보상과 예상 보상 간의 차이를 계산합니다.

○ 예상보다 보상이 높으면 도파민 활동이 증가.

○ 예상보다 보상이 낮으면 도파민 활동이 감소.

- 학습: 도파민 신호는 뇌의 신경 네트워크에 정보를 전달하여 미래 행동에 영향을 미칩니다. 이는 경험을 바탕으로 더 나은 결정을 내리는 데 도움을 줍니다.

도파민 회로는 특히 **중뇌의 복측피개 영역(VTA)**과 **선조체(특히 배측선조체)**에서 활성화되며, 감각 자극과 행동에 따라 보상과 벌의 신호를 학습하는 데 관여합니다.

3. 강화 학습과 도파민 회로의 유사점

- 보상 예측 오차: 강화 학습의 핵심 알고리즘(예: Q-learning)에서 사용되는 보상 예측 오차 개념은 도파민 회로의 작동 방식과 동일합니다. 예상 보상과 실제 보상의 차이가 행동 정책을 업데이트하는 데 사용됩니다.

- 시간차 학습 (Temporal Difference Learning): 강화 학습에서 시간차 학습은 상태 간 전이를 고려한 학습 방식을 설명하며, 이는 도파민 뉴런이 시간에 따라 보상을 처리하는 방식과 유사합니다.

- 장기적 학습: 도파민 시스템은 즉각적인 보상뿐 아니라 미래 보상의 기대값에도 영향을 미치며, 강화 학습의 장기 보상 최적화와 동일한 원리를 따릅니다.

4. 방법론적 비교

- 강화 학습 방법론: 강화 학습은 컴퓨터 알고리즘으로 구현됩니다. 보상 신호와 정책 업데이트를 기반으로 상태-행동 공간에서 최적의 경로를 찾습니다. 딥 러닝(Deep RL)을 활용하여 복잡한 환경에서도 높은 수준의 학습을 가능하게 합니다.

- 도파민 회로: 생물학적 시스템에서 뉴런의 활동과 시냅스 가소성을 통해 행동과 학습이 조정됩니다. 이는 본질적으로 병렬적이고 비선형적인 방식으로 작동합니다.

5. 응용과 학문적 함의

도파민 회로와 강화 학습 간의 유사성은 신경 과학과 인공지능 간의 교차 연구를 촉진합니다.

- 신경 과학 연구에서는 강화 학습 이론을 사용하여 도파민 시스템의 메커니즘을 해석합니다.

- 인공지능 연구에서는 생물학적 학습 시스템에서 영감을 받아 더욱 효율적인 알고리즘을 설계합니다.

이러한 상호작용은 인간의 학습 원리를 이해하는 동시에 인공지능의 발전에도 기여하고 있습니다.

<ifsPOST>

- 기사입력 2025년02월13일 17시10분

- 최종수정 2025년03월06일 18시28분

댓글목록

등록된 댓글이 없습니다.