열려있는 정책플랫폼 |

국가미래연구원은 폭 넓은 주제를 깊은 통찰력으로 다룹니다

※ 여기에 실린 글은 필자 개인의 의견이며 국가미래연구원(IFS)의 공식입장과는 차이가 있을 수 있습니다.

관련링크

본문

<내용 요약>

생성AI의 확산과 함께 인공지능 기술이 가진 잠재적 위험에 대한 우려가 고조되고 있다. 생성AI의 부정확성, 결과 해석을 어렵게 하는 블랙박스 모델과 같은 기술적 한계와 딥페이크, 사이버 공격 등 기술 오용으로 인한 사회적 피해에 대한 긴장이 높아지고 있다. 산학계의 인공지능 전문가들조차 인공지능이 인간이 이해할 수 없는 초지능으로 급속히 발전하면 자율 성장, 통제 상실 가능성이 높아져 인류의 실존을 위협할 수 있다고 경고한다.

이러한 상황에서 유럽연합은 2024년 5월 세계 최초로 인공지능 규제법인 인공지능법을 제정하였고, 미국은 2023년 10월 행정명령을 발동해 인공지능의 안전한 개발과 보급을 유도하고 있다. 2023년 11월 영국에서 세계 최초로 개최된 인공지능 안전성 정상회의는 인공지능 안전성 확보를 위한 국제 사회의 동참을 만들어 내는 계기가 되었다.

구체적으로 영국, 미국, 일본은 AI안전연구소를 설립하고, 첨단 AI의 안전성 테스트를 위한 프레임워크 개발과 정보, 인력 교류, 표준화에 상호 협력하기로 했다. 2024년 5월 제1차 인공지능 안전성 정상회의 후속으로 진행된 한국-영국 공동 주최 AI 서울 정상회의에서는 우리 정부도 AI 안전연구소 설립을 공식화하고 주요국과 함께 AI 안전성 확보를 위한 국제협력에 적극적 의지를 표명하였다.

향후 AI 안전 확보를 위한 정부의 역할이 더욱 중요해질 것으로 예상되는 가운데, AI 안전연구소는 AI 안전성 테스트 방법 및 프레임워크 개발, AI 안전성 확보를 위한 원천기술 개발 및 표준화, 그리고 이를 위한 정책연구와 민관협력, 국제 교류를 추진해 나갈 것으로 예상된다. 민간의 혁신을 저해하지 않고 사회와 산업에 안전한 인공지능을 도입·활용을 위해 AI안전연구소의 기능과 역할 정립이 요구되는 시점으로, 이 보고서에서는 영국, 미국, 일본 등 주요국의 AI안전연구소의 추진 동향을 살펴보고 국내 AI안전연구소의 역할을 모색한다.

I. 배경

■ 생성AI의 부상에 따라 인공지능의 다양한 위험에 대한 우려 고조

► ChatGPT가 촉발한 생성AI 기술이 확산되면서 AI 시스템의 오작동, 악의적 사용, 해석의어려움 및 위험을 가중시키는 여러 잠재 요인에서 비롯된 부작용에 대한 우려가 높아지고 있음

∙ 산학계 전문가들은 AI 기술이 빠르게 고도화됨에 따라 인간의 지능을 초월하고, 스스로 학습 진화하며, 인간의 통제를 우회하는 기술을 습득하게 될 경우 인류 사회의 실존적 위협이 될 것이라 경고

* (제프리 힌턴(Geoffrey Hinton)) “AI가 방대한 양의 데이터를 학습하는 과정에서 인간이 예상하지 못한 행동을 보이는 경우가있고, 이는 미래에 인류에게 위협으로 다가올 수 있다. – 서울경제와인터뷰(’23.5)”

* (요수아 벤지오(Yoshua Bengio)) “AI 시스템을 콘트롤하는 문제가 미래의 핵심 과제라고 할 수 있다. – 삼성AI포럼(’23.11)”

* (에릭 슈미트(Eric Schmidt)) “AI가 실존적 위험을 가하고 있다. 실존적 위험이란 아주 아주 많은 사람이 다치거나 죽는 것을 뜻한다. 우리는 악한 사람들이 이를 오용하지 않도록 대비해야 한다 – WSJ주최 CEO서밋(‘23.5)

자료: Yoshua Bengio et al.,(2024)1)

■ 이에, 유럽,미국 등 주요국은 법 제도를 정비하는 등 AI에 대한 본격적인 규제 움직임

► EU는 2024년 5월 세계 최초로 인공지능 규제법인 ‘인공지능법’을 제정하고 적용을 앞두고 있음

∙ EU AI Act는 AI의 위험 수준을 구분하고 수준별 차등 규제를 적용하고 있으며, 금지된 AI* 및 고위험 AI에대한 사업자 의무를 위반할 경우 최대 글로벌 연매출의 7%까지 달하는 벌금 조항을 포함

* EU AI Act는 사람들의 안전, 생계 및 권리를 명백하게 위협하는 AI의 사용을 금지하고 있음 (예, 생체정보 수집 및 식별, 잠재의식 조작, 사회적 평점 시스템, 특정 계층 취약성을 악용하는 AI)

∙ 또한, EU 역내에서 AI 제품 및 AI 서비스를 제공하기 위해서는 적합성 평가(conformity assessment)를받도록 하는 등 사업자 및 제공자의 의무를 강화

► 미국은 2023년 10월 연방 정부를 중심으로 인공지능의 안전성과 신뢰성을 확보하기 위한조치를 마련하는 백악관의 행정명령(EO 14110)을 개시 2)

∙ 백악관은 생성AI의 각종 오남용으로 인한 사회적 피해를 방지하고자 관련 기업들*을 초청해 기업들의 책임있는 AI 개발을 당부하고 기업들은 ‘자발적 약속(Voluntary AI Commitments)’을 발표(’23.7)

* 7개 AI 빅테크기업(아마존, 오픈AI, 메타, 인플렉션AI, 앤트로픽, 구글, 마이크로소프트)을 초청

■ 국제사회에서도 윤리적이고 안전하며 신뢰할 수 있는 AI개발 및 배포 촉구

► OECD는 지난 2019년 5월 인공지능 원칙 권고안을 채택했으며, 최근 주요 선진국들은 히로시마 G7 정상회의(’23.5)를 통해 책임있는 AI에 대한 국제 사회의 공조에 합의

► UN 회원국들도 안전한 AI의 개발과 활용을 촉구하는 결의안을 채택(’24.3)하는 등 국제 사회의안전한 AI 개발에 대한 공감대 확산

► 한편, 영국은 2023년 11월 세계 최초로 ‘인공지능 안전성 정상회의’를 개최하여 글로벌국가들로부터 인공지능 규제 필요성에 대한 공감대를 도출하고 국가 간 협력을 약속

* 우리나라를 포함한 미국, 중국, 영국 등 28개국과 EU가 공동으로 AI의 실존 위험에 대응하기 위해 AI에 대한 적절한 평가 지표를 마련하고 안전 테스트를 위한 도구를 개발하는 등의 국제 협력 방침을 담은 블레츨리 선언 발표

► 우리나라는 제1차 인공지능 안전성 정상회의 후속으로 2024년 5월 ‘AI 서울 정상회의’를영국과 공동 개최하고 안전하고 혁신적이며 포용적인 AI를 위한 ‘서울 선언’을 채택

∙ 세계 10개국 정상 및 EU 정상들이 공동으로 ‘서울 선언’을 채택했으며 국내외 14개 주요 기업이 책임 있는 AI개발과 활용을 위해 추구해야 할 방향을 담은 자발적 약속인 ‘서울 AI 기업 서약’을 발표

* (서울 AI 기업 서약) AI 안전연구소 피드백 반영, 첨단 AI 개발 투자 지속 및 중소·스타트업 성장 지원, 사회적 약자의 편의성을 개선하고 글로벌 도전과제 해결을 위한 AI 개발 등 지속가능한 AI 생태계 발전을 위한 기업의 책임 포함

■ 인공지능의 위험은 한 기업을 넘어 사회,국가 차원의 문제로 국가의 정책적 노력이 필요

► AI 위험은 단순 사용자를 넘어 시스템적 위험, 즉 선거 개입 및 민주주의의 오염, 실업 문제, 프라이버시 침해, 의료 및 금융사고 등 사회와 국가 전반의 위협을 초래할 가능성이 있음

► AI 산업 측면에서도 반도체, 클라우드, AI 플랫폼 등 AI 공급기업과 다양한 산업의 수요 기업이가치사슬로 엮인 특성으로 인해 AI 위험은 단위 기업이 아닌 산업 전체 차원의 대응이 필요

► 또한, 빅테크 기업이 여러 국가를 대상으로 제품 서비스를 제공함에 따라, AI 안전은 국가 간협력이 요구되는 사안으로 국가가 주도하는 AI 안전 정책의 필요성이 대두

■ 인공지능의 안전확보를 위한 각국의 정책적 노력은 AI안전연구소 설립으로 구체화

►영국은 2023년 11월 AI 안전성 정상회의를 개최하는 동시에 AI안전연구소의 설립을 발표하였으며, 순차적으로 미국(’23.12), 일본(’24.2)이 AI안전연구소를 각각 개소

► 캐나다는 2024년 4월 AI안전연구소 설립 계획을 발표하였고, 우리 정부도 2024년 5월 영국과공동 주최한 ‘AI 서울 정상회의’를 통해 AI안전연구소 설립을 공식화

► 향후, 각국의 AI안전연구소는 인공지능의 안전성 평가를 위한 프레임워크와 평가 도구 개발, 관련 연구 정보 공유, 인력 교류 및 국제표준화를 위해 긴밀한 협력*의 구심점을 할 것으로예상

∙ 미국 상무부(NIST)-영국 과학혁신기술부(AI 안전연구소)는 최첨단 AI모델 안전성 테스트 개발을 위한양해각서(MOU)를 체결(‘24.4) 3)하고, 미국-일본은 공동 성명을 통해 AI 안전연구와 협력 약속(’24.2) 4)

■ 해외 주요국들의 AI안전연구소 추진 동향을 검토하여 국내 AI안전연구소의 적절한 기능과 역할 모색

► AI 산업의 지속적 발전을 위한 토대가 되는 AI안전 확보를 위한 안전성 평가 체계, 핵심 기술, 국제협력, 표준화 등이 주요한 과업으로 부상

► 또한, AI 안전 규제가 AI 산업 발전을 위축시키지 않고, 지속적인 성장의 기반 역할이 될 수있으며 다양한 분야와 산업에 안전하게 융합될 수 있도록 적정 수준의 적용 방안을 수립할필요

► 이 보고서에서는, 해외 주요국의 AI안전연구소 추진 동향을 분석하여 AI 안전 확보를 위한거버넌스, 민관의 협력, 국제 사회와의 협력 체계 구축 및 AI 안전성 확보를 위한 핵심 원천 기술개발 등을 효과적으로 수행하기 위한 AI안전연구소의 주요 기능과 역할을 모색하고자 함

II. 해외 AI 안전연구소 현황

2.1 영국 5)

■ 영국 정부는 2023년 11월 AI안전성 정상회의를 계기로 ‘AI안전연구소’를 설립하였으며, 2024년 2월 AI 안전테스트 연구 초기결과를 발표하는 등 본격적인 연구활동을 시작

► 연구소는 과학혁신기술부(Dept. for Science, Innovation and Technology, DSIT) 산하기관으로 정부 내에 설립되었으며, AI 안전 R&D 역량 확대에 집중

∙ 초대 연구소장으로 Frontier AI TF 리더였던 이안 호가스(Ian Hogarth)가 선임되었으며, AI 안전연구팀의신속한 연구 지원을 위하여 정부의 권한과 민간 부문의 전문성, 민첩성이 결합 된 스타트업 형태로 구성*

* AI 안전연구팀의 신속한 연구 진행 지원을 위하여 과기혁신기술부 장관 미셀 도넬란(Michelle Donelan)에게 직접 보고

∙ 튜링상 수상자인 요수아 벤지오(Yoshua Bengio), 구글 딥마인드 출신의 AI 안전 전문가 제프리어빙(Geoffrey Irving), 옥스퍼드⼤ 인지신경과학 크리스토퍼 섬머필드(Christopher Summerfield)교수를 연구책임자로 영입하는 등 AI 전문가 영입에 주력*하고 있음

* 현재 연구소 인력은 AI 기술전문가 30여 명을 포함하여 100여 명 규모이며, 향후 기술전문가를 지속해서 충원할 계획(‘24.1.)

■ 연구소는 △첨단 AI시스템 위험성 평가, △AI안전 및 위험연구 촉진, △글로벌 AI개발 관행 및 안전정책 강화를 목표로 AI안전연구의 기능을 수행

자료: UK DSIT(2024.1)6) 보고서 토대로 저자 재구성

► 첨단 AI 시스템의 위험 평가를 통하여 정부와 정책입안자에게 AI 위험에 대한 정보를 제공하는것을 목표로 하며, 연구소에서 AI 안전성을 테스트할 수 있는 자체 역량 구축에 주력

∙ AI 안전 연구팀에게 선도 기업의 AI 모델에 대한 우선 접근 권한을 부여하며, 영국 AI 연구 자원 중 15억파운드(약 2조 4천억 원) 이상 규모 컴퓨팅 및 엑사스케일 슈퍼컴퓨팅 프로그램에 우선적 접근을 지원

► AI의 위험을 완화하고 공공의 이익에 기여하는 연구를 위하여 기업, 정부 및 광범위한 연구커뮤니티 간의 협력을 촉진하도록 지원

► AI 안전 정책 강화와 AI 안전 분야의 국제협력과 글로벌 리더십 확보를 위한 기반 확대

∙ 최근 미 샌프란시스코에 AI 안전연구소의 사무실 개소 계획을 발표하였으며(’24.5), 미국 내 연구소 개설은오픈 AI를 비롯한 미국 내 AI 연구소와 긴밀한 협력을 통해 파트너십을 강화하고, AI 모델에 관한 연구 공유및 공동 평가를 통해 공공 이익을 위한 AI 안전 증진을 목적으로 함 7)

■ 영국 AI안전연구소는 AI안전정책 결정 및 공공의 책임성 강화를 위하여 첨단AI에 대한 이해 제공을 최우선 목표로 하며 안전성테스트 수행 및 R&D역량 구축에 주력

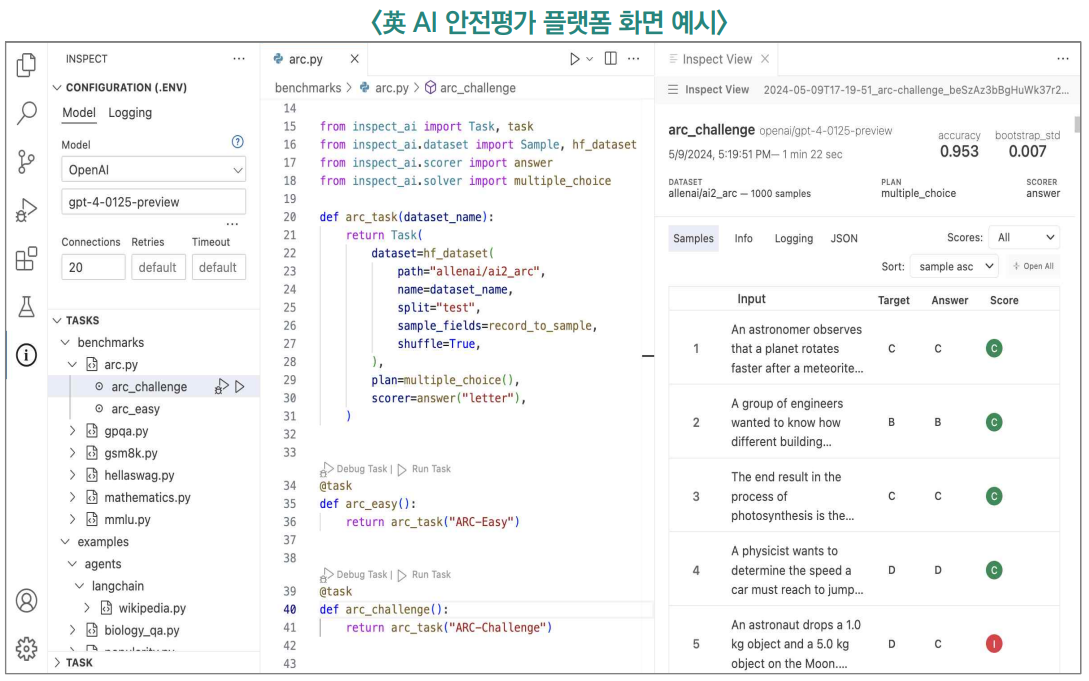

► 최근 제 4차 경과보고서를 통하여 AI안전연구소의 주요 활동내역을 보고하고, 첨단 AI 모델의안전 테스트 결과와 AI안전 평가 플랫폼인 인스펙트(Inspect)를 공개 (‘24.5) 8)

∙ 연구소는 5개 거대 언어 모델(LLM)에 대하여 사이버 공격, 화학 및 생물학적 오용 가능성, 자율성, 유해한결과물 도출 가능성 등을 자체적으로 평가하여 결과를 공개

* 평가대상인 5개 LLM은 비공개로, 각 모델에 대해 질문 또는 작업 프롬프트를 제공하고 응답을 측정하는 방식으로, 유해한 요청에 대한 준수(compliance), 정확한 응답(correctness), 작업의 완수(completion)에 대해 측정

► ‘인스펙트’는 다양한 이해관계자에게 용이한 AI 안전 평가 환경을 제공함으로써, 고품질의안전성 평가 체계를 마련하고 이를 통해 산·학·연의 상호 조율이 가능할 것으로 기대

∙ AISI는 인스펙트를 글로벌 AI 커뮤니티에 오픈소스 형태로 공개하고, 개별 AI 모델의 기능 평가 및 점수산출을 위한 기능을 제공(’24.5) 9)

* Inspect는 핵심 지식, 추론 능력, 자율 능력 등 다양한 영역의 모델 평가가 가능하도록 구성되었으며, 프롬프트 엔지니어링, 도구 사용, 다중회전 대화 및 모델의 등급 평가를 위한 기능 등을 포함 [참고1]

2.2 미국

■ 미 백악관은 ’안전하고 신뢰할 수 있는 인공지능 개발 및 사용에 관한 행정명령’에 근거해, 2023년 11월 AI안전성 정상회의에서 ‘AI안전연구소’ 설립 발표

► 미 AI안전연구소는(USAISI) 연방 정부 기관인 상무부 산하 국립표준기술연구소(NIST) 내에설치되었으며, 안전하고 신뢰할 수 있는 AI의 개발·배포를 위해 민간 컨소시엄 구축을 통한글로벌 표준 확립에 주력

∙ 연구소의 초대 소장으로 엘리자베스 켈리(Elizabeth Kelly)* 전 백악관 특별보좌관을, 최고기술책임자(CTO)로는 NIST 정보기술연구소(ITL)의 수석 과학자인 엘함 타바시(Elham Tabassi)를 선임

* 엘리자베스 켈리는 예일대 로스쿨 법학박사 출신으로, ‘AI 행정명령’ 설계에 핵심 역할을 수행한 것으로 알려짐 [참고3]

► NIST는 2023년 1월 AI 위험관리 프레임워크(AI RMF) 1.0을 개발하고, 관련 센터 및 워킹그룹설립을 추진해왔으며*, AI안전연구소를 통해 AI 안전 연구 및 개발, 국제협력 수행∙ 신뢰할 수 있고 책임있는 AI 리소스 센터(AIRC)는 2023년 3월 설립하여 AI RMF와 가이드라인인플레이북을 지원 및 운영 ∙ 생성 AI 공개 워킹그룹을 구성해 거버넌스, 콘텐츠 출처, 배포 전 테스트, 사건·사고 공개 영역에 대한프로필을 개발하여 위험 해결을 위한 가이드라인 제공(’23.7)

■ 연구소는 △AI안전기초연구, △ AI안전테스트 프레임워크 개발, △ AI안전 국제협력을 포함하여 안전한 AI혁신을 위한 기능을 수행

► AI 안전 과학의 진보, AI 안전 관행 개발 및 전파, AI 안전 관련 기관·커뮤니티 지원 및 조정의목표 달성을 위해 연구, 구현, 컨소시엄 관점에서 세부 기능을 정의

자료: US AISI Workshop (2023.11)10)

■ 미국 AI안전연구소는 안전한 AI개발 및 배포 관련 기술표준 수립을 위해 2024년 2월 대규모 AI안전연구소 컨소시엄(AISIC)을 발족하고, 공공-민간협력체계를 구축

► 레드티밍, 성능 평가 등에 대해 민간과 협업하기 위한 협력 체계로, 자국 기업을 중심으로 구성

∙ 컨소시엄은 미국 내 AI 관련 기업 등 200개 이상의 회원사*와 대학, 연구기관 등으로 구성

* 주요 참여기업은 △(빅테크) 구글, MS, 메타, 애플, 아마존, 엔비디아, 인텔, IBM, 퀄컴, 어도비 등, △(스타트업) 오픈AI,앤트로픽, 코히어, 허깅페이스 등 △(금융) JP 모건, 뱅크 오브 아메리카 등

► AI 안전 확보를 위한 5개의 주요 요소를 중심으로 워킹그룹을 구성하고 실질적 연구 및 개발을 수행하여, 안전성 평가 토대를 마련하고 표준화를 위한 플랫폼을 제공할 것으로 기대

자료: NIST AISIC(2024.2) 11)

■ 또한 미국은 영국,일본 등의 주요국과 글로벌 협력 네트워크를 형성하며 AI안전연구 가속

► 미국 상무부는 영국 과학혁신기술부와 세계 최초로 AI 안전에 대한 연구와 평가 및 지침 개발을위한 양해각서(MOU) 체결 (‘24.4)

∙ 미국과 영국의 AI안전연구소는 AI 시스템의 테스트에 대해 공통적 접근 방식을 수립하고, 공개된 모델에대한 공동 테스트 수행, 위험 해결을 위해 정보 공유와 인적 교류 등 긴밀한 국가협력 체계 구축

2.3 일본 12)

■ 일본 정부는 AI 안전성 정상회의, G7 히로시마 AI 프로세스 합의 등을 계기로 AI안전연구소를 설립(’24.2.14)하였으며, AI의 안전성 향상을 위한 업무를 수행

► 연구소는 ⽇ 경제산업성 산하 기관인 정보처리추진기구(Information Technology PromotionAgency, IPA)* 내에 설립되었으며, 운영위원회, 사무국 등을 통해 사업의 운영 및 심의를 추진

* IPA는 보안센터(IPA/ISEC) 운영, IT 보안 평가 및 인증제도(JISEC) 등을 담당하는 기관

∙ 초대 연구소장으로 무라카미 아키코*를 선임(‘24.2)하였으며, 소장을 위원장으로 하는 AISI 운영위원회를통해 사업 운영에 관한 주요 사항을 심의하는 구조

∙ 초대 연구소장으로 무라카미 아키코*를 선임(‘24.2)하였으며, 소장을 위원장으로 하는 AISI 운영위원회를통해 사업 운영에 관한 주요 사항을 심의하는 구조

* 1999년 일본 IBM에 입사하여 손해보험 재팬 주식회사 최고디지털임원(CDO)을 역임한 여성 정보통신전문가

► 내각부를 사무국으로 하는 ‘AISI 관계부처 연락회의’를 설치하고, AISI 사무국으로 IPA 디지털기반센터 중 5개 팀*을 편성하여 연구소 업무를 수행하도록 편성

* 기획팀, 프레임워크팀, 보안팀, 표준팀의 5개 팀을 중심으로 업무 수행 예정∙ 연간 2~3회의 AISI 관계부처 연락회의*를 통해 중요사항을 심의하고, AISI 운영위원회 회의는 월 1회개최하며, 필요에 따라 주제별 분과위원회 설치 및 파트너십 사업 구성 계획을 논의하도록 운영 체계 구성

* 내각부 과기정책담당 주관하에 1차 AISI 관계부처 연락회의(‘24.2.29)13)를 개최하고, 연구소 운영 및 추진계획을 논의하였으며, 2024년 6월 제2차 연락회의를 통해 AISI의 추진 성과 및 향후 계획을 공유

■ 연구소는 △ AI안전 평가 및 기준 조사·연구, △ AI안전성 평가와 실시방안 조사·연구, △미·영 AISI 등 국제관계기관과 협력 업무를 중점적으로 수행

자료: ⽇내각부-IPA(’24.2.29.)14)

■ 일본 AI안전연구소는 정부·관계부처· AI안전연구소를 중심으로 AI안전관련 정책 및 업무를수행할 수 있도록 체계화시키고, AI안전분야의 미·일 협력을 본격화

► 일본 AI안전연구소는 미국과 일본의 AI 위험관리 프레임워크의 상호운용성 개선을 위한 1차크로스워크(Cross walk)* 결과물과 향후 추진 계획을 발표(‘24.4) 15)

* ‘크로스워크’란 AI 법률 및 규정, 표준 및 프레임워크의 조항을 하위 범주에 매핑하는 것으로, 이를 토대로 조직의 규정 준수촉진을 위한 활동과 결과의 우선순위를 정하는 작업

∙ 일 AI 비즈니스 가이드라인(AI Guidelines for Business, GfB)*과 미 NIST의 AI RMF의 용어에 대한상호 검증 1차 결과를 발표(‘24.4)

* AI 관련 이해관계자가 AI 위험을 정확하게 파악하고 대비할 수 있도록 관련 당사자와 프레임워크를 공동 구축하는 것을 목표로추진 중이며, 인간중심 AI의 사회적 원칙에 기반하여 세 가지 지침(인간 중심 원칙, R&D 지침, 활용 지침)을 통합하여 구성

∙ 향후, ⽇ AI GfB와 미 NIST의 RMF의 거버넌스(Governance), 계획(Map), 측정(Measure),관리(Manage) 등 4 가지 기능에 대한 추가 크로스워크 진행 예정

► 그 외, AI안전연구소를 중심으로 미국, 영국, EU, 싱가포르 등 주요국과 AI 안전 관련 의견 교류, 국제 행사 및 정상회의 참석, 스탠포드 대학교 AI 심포지엄 참가 등 국제협력 활동 추진

2.4 기타 국가

■ 2023년 11월 영국인공지능 안전성 정상회의 결과인 블레츨리선언에 참여한 국가는 AI위험에 대응하기 위한 도구 및 평가지표 개발, 국제협력 등에 상호노력하기로 합의

► 영국, 미국, 일본을 포함하여 캐나다, 프랑스, 호주, 싱가포르 등 각국에서 AI 안전 연구를 전담할기관을 설립하거나 기존 설립된 기관에 역할을 부여

■ (캐나다) 2024년 4월 AI 사업 활성화와 안전을 위한 예산(안)을 발표하였으며, 예산(안)에AI안전연구소 설립을 포함

► 저스틴 트뤼도 총리는 AI 안전연구소 설립 예산(5,000만 CAD)을 포함한 2024년예산계획(안)을 공개

∙ 캐나다 연구 환경에 적합한 AI 안전성과 윤리 연구 인프라의 필요성을 강조하였으며, AI안전연구소를포함한 AI 산업 활성화를 통해 AI 경쟁우위 확보를 목표

► 또한, 영국과 캐나다는 AI 안전을 위한 파트너십을 체결(’24.5)

∙ AI 안전성 테스트 및 평가 작업을 강화하기 위한 전문 지식 공유 채널 구축, 전문가 교환 및 파견을 촉진하기위한 조치 마련, 컴퓨팅 자원 공유*, 첨단 AI 시스템의 안전과 관련된 표준의 개발·수립·구현에 대한 양국작업의 정기적 정보 교환, 관련 국제 포럼이나 기구에서의 상호 의견 조율 촉진 등을 포함

* 영국 AI안전연구소(AISI)는 공동 연구를 위해 캐나다 AI안전연구소가 영국의 AI 자원에 접근할 수 있도록하며, 영국과 캐나다의AI안전연구소는 미국 AI안전연구소와 함께 AI가 도입되고 있는 사회 시스템의 안전을 보호하는 "시스템적 AI 안전" 분야의 연구 프로그램에서 협력 계획

■ (프랑스) 영국과 AI안전을 위한 협력파트너십을 발표(‘24.2)하였으며,2025년 초 차기 AI안전정상회의를 준비

► 영국 AI 안전연구소와 프랑스 인리아(INRIA, 프랑스 컴퓨터 과학 및 자동화 연구소) 간 새로운파트너십을 구축하여 AI 기술의 안전하고 책임감 있는 개발을 위한 협력 추진 16)

► 프랑스는 2025년 2월 차기 AI 안전 정상회의인 ‘AI 행동 정상회의(AI Action Summit)’를개최하여 국제 사회에서 새로운 AI 규범 수립을 주도할 계획 17)

■ (호주)국립 AI센터(NationalAICentre)가 AI안전표준을 개발할 계획

► 2024년 1월 호주 정부는 고위험 AI 애플리케이션에 관한 규제, 국립 AI 센터를 통한 AI 안전표준 개발 계획, AI 업계와의 협력 등의 계획을 발표 18)

► 국립 AI 센터는 호주의 AI 산업 생태계를 위한 산업 협력 연구, 기후 기술을 위한 AI, 책임감 있는AI 사용을 위한 지침, 도구, 학습 기회 제공 등을 통해 호주의 AI 역량 강화를 목표

► 현재 연방과학산업연구기구(CSIRO) 산하인 국립 AI 센터를 향후 산업과학자원부(DISR)산하로 승격할 예정

■ (싱가포르) 싱가포르국립대학교(NUS)에 공익을 위한 AI연구소를 설립

► AI연구소(NAII)는 AI 기반 모델 및 산업융합 연구를 촉진하고, AI 인재를 육성하며, 산학 * 협력과 스타트업 생태계 활성화에 이바지하기 위한 목표로 설립

* IBM, 구글 클라우드가 산업 파트너로 참여하여 기술 발전과 사회적 영향력을 촉진하는 것을 목표로 연구를 수행하고 산업도메인 애플리케이션 개발에 협력하며, 현지 기업 및 해외 기업과 협력 모색

► 특히, AI와 관련 윤리적 우려와 위험을 해결하기 위해 안전성, 신뢰성, 투명성, 책임성 연구와관련 규제 방안도 연구

► 프론티어 AI를 위한 기반 모델 기술 연구와 함께, 개인정보 보호를 위한 기술개발, 설명가능한 AI신뢰성 평가 도구 연구, AI 거버넌스·정책 연구 등을 추진

■ 세계 각국은 책임있는 인공지능 구현과 확산을 위해 AI안전 확보를 위한 전담조직을 준비

► 인도는 AI 기술개발 및 적용을 규제하기 위한 규제 프레임워크의 개발, 자동화로 인한 근로자대체 등 AI로 인한 사회문제 해결을 위한 국립 연구소 설립을 논의*19)

* 인도의 전 과학산업연구위원회(CSIR) 사무총장이자 화학 분야 석학인 Raghunath Mashelkar 박사는 AI의 유익한 확산을위해 국립 AI안전연구소 설립을 옹호(’24.5.18)

► 이스라엘은 2023년 12월 발표된 AI 규제 및 윤리 정책*에 정부 AI 정책 개선, AI 규제 관련 논의, 국제 사회와의 협력을 추진하면서 책임 있는 AI 개발 및 사용을 실현하는 전문가 중심의 AI 정책조정 센터 (AI Policy Coordination Center) 설립을 명시 20)

* OECD의 AI 권고에 맞춰 편견, 투명성, 안전, 책임 및 개인 정보 보호와 관련된 우려를 해결하는 동시에 혁신을 촉진하는프레임워크를 구축하기 위한 이스라엘 정부의 AI 정책

► 사우디아라비아는 수도 리야드에 AI 연구 및 윤리를 위한 국제 센터(International Center forAI Research and Ethics) 설립을 2023년 11월에 발표하였으며, 이를 통해 AI 및 첨단 기술분야의 역량과 입법 체계를 발전시킬 계획을 수립 21)

► 르완다는 다보스 세계경제포럼과 협력으로 설립된 4차 산업혁명 센터(Centre for the FourthIndustrial Revolution)에서 개인정보 보호, 의료분야에서의 책임 있는 챗봇 사용을 위한프레임워크 연구를 추진

III. 시사점

■ AI산업의 지속적 발전을 위해 AI 안전성 확보가 주요 선결과제로 부상

► 미·영·일 등 주요국 AI안전연구소는 AI안전정책을 수립하고, AI 안전성을 평가할 수 있는프레임워크 및 테스트 방법론 개발, 기반 기술 연구 및 국제협력을 중점적으로 추진 중

► (AI 안전 테스트 프레임워크) AI 개발 전주기에 걸쳐 AI 안전성을 확보하기 위한 절차와 검토사항을 점검하여 설계에서 배포까지 인공지능의 안전성을 강화하기 위한 프레임워크를 개발

∙ 이를 위해, 평가 데이터 세트, 벤치마크 및 평가 방법, 평가 도구, 평가 플랫폼 등을 자체 구축

► (핵심 기반 기술 연구) 갈수록 고도화되는 AI 모델의 잠재적 역량을 파악하고, 위험원을식별하며, 모델의 편향성을 제거하고 설명가능성을 높이는 원천기술 개발

∙ 딥페이크와 같은 기술 오용 및 학습데이터와 AI 모델을 타겟으로 한 사이버 공격 대응 기술 개발 병행

► (AI 안전 정책) 급변하는 AI기술, 산업 동향, 국제 정세를 분석해 AI의 잠재적 위험, 사건 사고, 대응 방안 등 AI 안전 확보를 위한 국가 정책 개발∙ 기본권 침해, 가짜정보 확산 및 일자리 대체 등 AI 기술의 사회·경제적 영향평가, AI 사건·사고 발생시 이해관계자 간 책임 소재 명확화, 글로벌 AI 규제 대응 방안을 포함해 종합적인 AI 정책 수립 지원

■ 국가AI전략 및 글로벌AI규범 정합성을 확보하는 AI안전거버넌스 확립

► (리더십) 각국은 AI안전연구소의 책임자에 AI 분야 전문가를 임명하였으며, 이들에게 민간 기업및 연구자와의 협력 체계 및 주요 의사결정 권한을 부여

► (거버넌스) 국가 인공지능 전략 및 글로벌 인공지능 규범과의 정합성을 확보하고 AI안전 정책 및기술개발의 구심점 역할을 할 수 있는 거버넌스 수립

∙ 국가 최고 수준의 인공지능 정책 기구(예, 국가인공지능위원회)에서 국가 인공지능 전략, 법제도 및 EU의AI Act 등 글로벌 AI 규제 수준에 부합하는 안전성 확보 정책 개발

∙ AI를 기반 기술로 활용되는 공공, 민간 영역에서의 안전성 확보 및 사고 대응 체계 구축 정책 수립

* AI 안전 관련 최신 정책 및 산업 동향, 위험원, 사고사례, 배포 후 모니터링 및 정보 확산 체계 구축

∙ 인공지능 안전 평가 방법 및 연구 인프라 구축, 표준, 글로벌 협력, 정책, 법제도 수립 등 AI 안전 확보를 위한 AI 안전연구소의 기능을 정의하고 민간의 우수한 인력과 기술을 도입할 수 있도록 법 근거 마련 필요

■ 선도적 AI안전관리 역량 확보를 위한 민관협력체계 구축

► 최신 산업 기술 및 글로벌 규제 체계에 부합한 AI 안전성 평가 프레임 워크 공동 개발

∙ 선도 AI 기업들은 자체적인 AI 위험관리 프레임워크*를 개발하고, 다양한 AI 역량을 테스트하며 잠재적 위험을 최소화하는 방법을 마련하고 있어 이러한 민간 역량을 공공에 적용시킬 수 있는 체계 필요

* (앤트로픽) Responsible Scaling Policy(‘23.9), (오픈AI) Preparedness Framework beta(’23.12), (구글 딥마인드)Frontier Safety Framework(’24.5), (네이버) 인공지능 안전 프레임워크(’24.6)

► 첨단 AI의 공공 도입을 위한 가이드라인 마련 및 AI 안전 인·검증 체계 개발 협력

∙ AI 안전성 검·인증 기업, 표준 기관, 규제 기관, 정부가 참여하는 AI안전 생태계 육성 추진

* 영국은 ‘인공지능 보장 생태계 로드맵(’21.12)’을 수립하고 제3자 기관이 인공지능의 책임성, 안전성을 보장하는 형태의 산업생태계 전략을 발표하고 추진 중

∙ 지속적인 AI 법제 개선 과제를 발굴하고 AI 시스템 또는 서비스 실패에 따른 책임 소재의 명확화

* AI법제정비단의 주요 추진 과제인 ’인공지능 법인격 및 책임체계 정립‘을 가속화하여 ‘AI 창작물 권리관계 정리 및 민형사상 법인격 인정’ 그리고 ‘AI에 의한 계약 효력을 명확화’할 필요 22)

■ 글로벌 AI안전규범 리더십 확보를 위한 국제표준화와 국제협력 추진

► EU, 미국, 영국 등 주요국들은 AI안전기술 개발과 국제 표준화를 연계해 산업 경쟁력의 원천으로서 AI 안전 기술 리더십을 확보

∙ 영국은 ‘AI표준허브*’전략과 연계해 AI 안전·신뢰성 기술의 글로벌 표준화를 추진하고, 미국도 상무부 산하 국립표준기술연구소(NIST) 아래 AI 안전연구소 설립해 신속한 표준화 추진

* 영국 정부는 앨런튜링연구소, 영국표준협회(BSI), 국립물리연구소(NPL)와 함께 인공지능의 글로벌 기술 표준을 주도할 ‘AI 표준허브’를 시범 운영하는 이니셔티브 발표 (‘22.1)

► 각국의 AI안전연구소는 인공지능 안전성 정상회담과 후속 회의 등 국제협력을 지원하고, 정보공유, 인력 교류, 공동 연구 등 국가 간 AI 안전 관련 협력을 추진

* AI 안전 관련 국가 간 협력(MOU)을 체결한 미국과 영국은 각국의 AI 안전연구소가 실제적인 협력 교류 활동을 담당할 예정이며, 미국-일본 역시 AI 안전 프레임워크 및 표준 개발 등 각국 AI안전연구소를 중심으로 협력 추진 예정

■ AI가 주도하는 글로벌 디지털 사회의 공공의 안전과 유익을 위한 AI안전성평가 확보와 이를 위한 기술개발 및 표준수립 및 국제협력의 허브로서 AI안전연구소의 역할 필요

<참고1>

영국 AI안전연구소,새로운 AI안전성 자체 평가 플랫폼 출시

<영국 AI안전평가 플랫폼 인스펙트(Inspect)>

ㅇ 영국 AI안전연구소는 AI 안전성 테스트 플랫폼인 ‘Inspect’를 깃허브에 공개(‘24.05.10)

- ‘인스펙트’는 글로벌 안전성 평가를 강화하고 가속화하기 위해 영국에서 새롭게 구축한 새로운AI 안전성 테스트 플랫폼

- 글로벌 개발자 커뮤니티인 깃허브에 공개해 다양한 그룹이 AI 평가를 더 쉽게 개발할 수 있도록 지원하며 연구자 및 개발자와의 협업 강화를 도모

- 인스펙트 출시와 함께 AI 안전연구소, AI 인큐베이터(i.AI), 총리실(Number 10)은 다양한분야의 AI 인재를 모아 새로운 오픈소스 AI 안전 도구를 빠르게 테스트하고 개발할 예정

* i.AI: 각 부처가 AI의 잠재력을 활용하여 국민의 삶과 공공 서비스 제공을 개선하도록 돕기 위해 기술 전문가들로구성된 조직(‘23.11)으로 실질적인 AI 도구 개발 수행

ㅇ 인스펙트는 스타트업, 학계, AI 개발자부터 정부에 이르기까지 테스터가 개별 모델의 특정기능을 평가하고 그 결과에 따라 점수를 산출할 수 있는 소프트웨어 라이브러리

* 평가 플랫폼은 대규모 언어 모델 평가를 위한 오픈소스 프레임워크로 핵심 지식, 추론 능력, 자율 능력 등 다양한영역의 모델 평가가 가능하도록 구성

ㅇ ‘인스펙트는 프롬프트 엔지니어링을 위한 도구, 멀티턴 대화 상자 및 모델 채점 평가를 위한기능을 포함한 많은 기본 구성 요소(built-in components)를 제공

참고 2> AI 서울정상회의 서울선언 및 의향서

----------------------------------------------------------------------------------------------------------

1) Yoshua Bengio 외 (2024.5.17.), International Scientific Report on the Safety of Advanced AI: INTERIM REPORT

2) The White House(2023.10.30.), Executive Order 14110, Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence

3) U.S. Deparment of Commerce (2024.4.1.), U.S. and UK Announce Partnership on Science of AI Safety

4) U.S. Department of State (2024.2.27.), Joint Statement from the 14th U.S.-Japan Dialogue on Digital Economy

5)UK AISI(AI Safety Institute), https://www.aisi.gov.uk/

6) Dep’t for Science, Innovation and Technology and AI Safety Institute(2024.01.17), Introducing the AI Safety Institute

7) Gov.UK(2024.5.20.), Government's trailblazing Institute for AI Safety to open doors in San Francisco

8) AISI(2024.5.20.), Fourth progress report

9) AISI(2024.5.20.), Advanced AI evaluations at AISI: May update

10) NIST(2023.11.17), A USAISI Workshop: Collaboration to Enable Safe and Trustworthy AI

11) NIST(2024.2), Artificial Intelligence Safety Institute Consortium (AISIC)

12) AISI Japan, https://aisi.go.jp/

13) ⽇ 内閣府(2024.2.29.), AIセーフティ・インスティテュート(AISI)関係府省庁等連絡会議(第1回)

14) 内閣府 과학기술혁신추진사무국, IPA AI안전연구소(2024.2), AIセーフティ・インスティテュート(AISI)の 今後の活動について

15) Japan AISI (2024.4.30), AI事業者ガイドラインと⽶国NIST AIリスクマネジメントフレームワーク(RMF)とのクロスウォーク

16) Techerati (2024.2.29.), UK and France forge stronger research and AI collaboration

17) 프랑스 대통령실 (2024.5.22.). Gathering of France’s top AI talents

18) Herbert Smith Freehills (2024.1.18.), Australian Government announces mandatory regulation for high-risk AI

19) Moitra, S., (2024.5.18.) India’s AI Safety Institute should strike balance between ‘prevention’ and ‘promotion’, says

Raghunath Mashelkar

20) Ministry of Innovation, Science and Technology (2023.12.17.), Israel’s Policy on Artificial Intelligence Regulations and Ethics

21) IFACCA (2023.11.11.), Saudi Arabia unveils International Center for AI Research and Ethics in Riyadh

22) 과학기술정보통신부 보도자료(2020.12.24.), 인공지능 시대를 준비하는 법·제도·규제 정비 로드맵 마련

◈ 참고문헌

<국외문헌>

○ Yoshua Bengio et al.,(2024.5.17.), International Scientific Report on the Safety of Advanced AI:INTERIM REPORT

○ The White House (2023.10.30.), Executive Order 14110, Safe, Secure, and TrustworthyDevelopment and Use of Artificial Intelligence

○U.S. Deparment of Commerce (2024.4.1.), U.S. and UK Announce Partnership on Science of AI Safety

○ U.S. Department of State (2024.2.27.), Joint Statement from the 14th U.S.-Japan Dialogue onDigital Economy

○ UK AISI(AI Safety Institute), https://www.aisi.gov.uk/

○ UK DSIT and AI Safety Institute(2024.01.17), Introducing the AI Safety Institute

○ Gov.UK (2024.5.20.), Government's trailblazing Institute for AI Safety to open doors in San Francisco

○UK AISI (2024.5.20.), Fourth progress report

○ UK AISI (2024.5.20.), Advanced AI evaluations at AISI: May update

○ NIST(2023.11.17.), NIST-USAISI Workshop: Collaboration to Enable Safe and Trustworthy AI

○ NIST(2024.2), Artificial Intelligence Safety Institute Consortium (AISIC)

○ Japan AISI, https://aisi.go.jp/

○ ⽇, 内閣府(2024.2.29.), AIセーフティ・インスティテュート(AISI)関係府省庁等連絡会議(第1回)

○ Japan AISI (2024.4.30.), AI事業者ガイドラインと⽶国NISTAIリスクマネジメントフレームワーク(RMF)とのクロスウォーク

○ 内閣府 과학기술혁신추진사무국, IPA AI안전연구소(2024.2),AIセーフティ・インスティテュート(AISI)の 今後の活動について

○ Japan AISI (2024.4.30.), AI事業者ガイドラインと⽶国NISTAIリスクマネジメントフレームワークRMF)とのクロスウォーク

○ Techerati (2024.2.29.), UK and France forge stronger research and AI collaboration

○ Herbert Smith Freehills (2024.1.18.), Australian Government announces mandatory regulation for high-risk AI

○ Moitra, S., (2024.5.18.) India’s AI Safety Institute should strike balance between ‘prevention’ and‘promotion’, says Raghunath Mashelkar

○ Ministry of Innovation, Science and Technology (2023.12.17.), Israel’s Policy on ArtificialIntelligence Regulations and Ethics

○ IFACCA (2023.11.11.), Saudi Arabia unveils International Center for AI Research and Ethics in Riyadh

○ 프랑스 대통령실 (2024.5.22.). Gathering of France’s top AI talents

<국내문헌>

○ 과학기술정보통신부 보도자료(2020.12.24.), 인공지능 시대를 준비하는 법·제도·규제 정비 로드맵 마련

○ 대통령실(2024.5.21.), AI 서울 정상회의 서울선언 및 의향서

◈ 저자

▲ 유재흥 AI정책연구실 책임연구원

▲ 노재원 AI정책연구실 선임연구원

▲ 장진철 AI정책연구실 선임연구원

▲ 조지연 AI정책연구실 선임연구원

<ifsPOST>

※ 이 자료는 소프트웨어정책연구소(SPRi)가 발간한 [SPRi 이슈리포트 IS-175] (2024.7.23.)에 실린 것으로 연구언의 동의를 얻어 게재합니다. <편집자> |

- 기사입력 2024년07월26일 20시00분

- 최종수정 2024년07월26일 19시52분

댓글목록

등록된 댓글이 없습니다.